禁止 ChatGPT 爬蟲 GPTBot 爬取網站內容作為 AI 訓練教學

OpenAI旗下AI對話式機器人ChatGPT今年爆紅之後,有許多人在探討如何阻擋AI機器人利用自己的內容來進行AI語言模型訓練,這部分爭議非常大,其實在OpenAI的官...

OpenAI:ChatGPT将遵守爬虫协议,网站可拒绝白嫖

- python反爬蟲

- python爬蟲實作

- block chatgpt in firewall

- chatgpt google

- Google map robots txt

- chatgpt中文版

- 生成式AI幻覺

- chatgpt登入

- chatgpt opt out

- 翻譯

- GPTs GitHub

- chatgpt怎麼用

- chatgpt api

- 玉山ai

- robots.txt generator

2023年8月9日—只要在网站的robots.txt中加入如下内容:.User-agent:GPTBot.Disallow:/.这样,GPTBot将不会访问你的网站进行内容抓取。如果只想禁止GPT抓取 ...

** 本站引用參考文章部分資訊,基於少量部分引用原則,為了避免造成過多外部連結,保留參考來源資訊而不直接連結,也請見諒 **

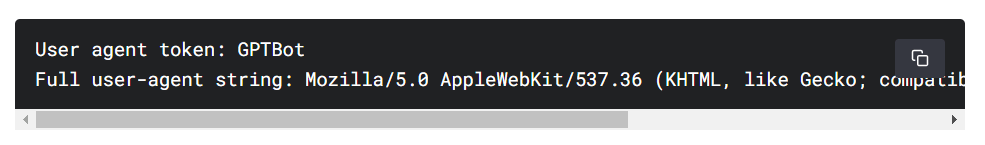

根據 OpenAI 官方文件表示,User-agent 為 GPTBot。User-agent 字串如上圖。下面幫大家列出,可直接複製使用:

根據 OpenAI 官方文件表示,User-agent 為 GPTBot。User-agent 字串如上圖。下面幫大家列出,可直接複製使用: