alphago演算法

2017年12月9日—如今,完全無需人工特徵、無需任何人類棋譜,甚至無需任何特定最佳化的通用強化學習演算法AlphaZero問世,且只需幾小時的訓練時間就可以超越先前最好的 ...,2016年12月27日—AlphaGo利用深度學習,透過的策略網路和估值網路分別大幅減少計算的廣度和深...

淺談Alpha Go所涉及的深度學習技術

- alphago人工智慧

- google alphago

- alphago下載

- alphago人工智慧

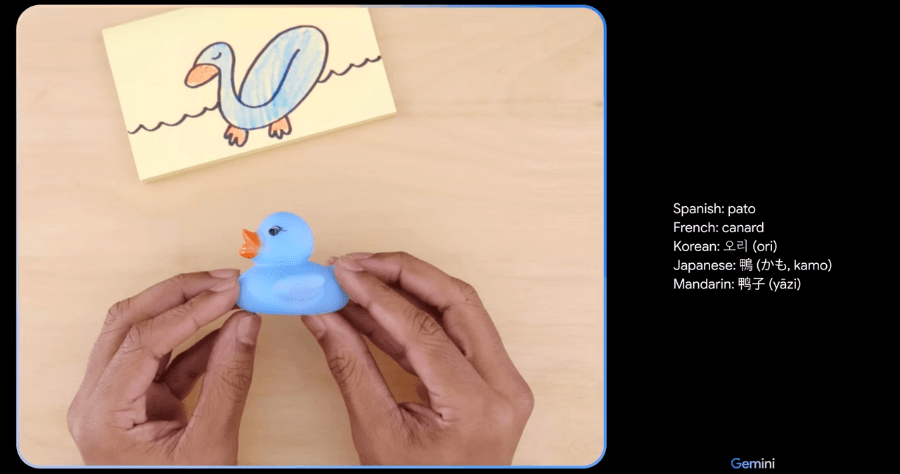

- 圖解人工智慧

- google ai圍棋

- alphago圍棋

- 人工智慧下棋

- alphago下載

- alphago圍棋

- 圍棋ai下載

- google人工智慧api

- google chrome下載檔案

- google ai tensorflow

- google圍棋

- google人工智慧alphago

- google ai工具

- alphago圍棋

- 圍棋ai下載

- alphago人工智慧

- google人工智慧api

- google語音助理

- alphago人工智慧

- 人工智慧象棋

- google chrome 打不開

2016年3月14日—AlphaGo技術的最後環節就是蒙地卡羅搜尋樹,相較於以前深藍所使用的搜索(搭配MinMax搜索算法以及Alpha-Beta修剪法,這裡就不再贅述),由於我們並非具有 ...

** 本站引用參考文章部分資訊,基於少量部分引用原則,為了避免造成過多外部連結,保留參考來源資訊而不直接連結,也請見諒 **